Видео включает два доклада:

"Fast reinforcement learning with generalized policy updates"

Одной из важных проблем в обучении с подкреплением является то, что зачастую, чтобы выучить удовлетворительную политику, нужно провести достаточно большое число взаимодействий агента с окружением.

Авторами рассматриваемой статьи предлагается решать эту проблему с помощью подхода «разделяй и властвуй».

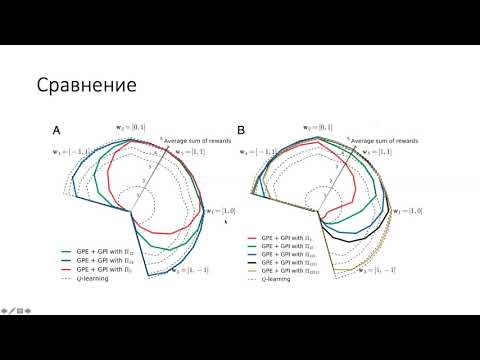

Часто, сложную задачу можно представить в виде последовательно или параллельно выполняемых простых задач. Для такого перехода авторами вводятся обобщенные версии policy evaluation и improvement. Таким образом, можно использовать решение одной задачи для решения других.

Решение авторов помогает добиться сильного прироста в скорости сходимости алгоритмов обучения с подкреплением (алгоритм сходится на несколько порядков быстрее Q-learning).

Докладчик: Сергей Полежаев.

"Evolving Reinforcement Learning Algorithms"

Существует множество различных применений обучения с подкреплением: начиная с настольных игр и заканчивая беспилотными системами. Однако, не так много работ посвящено попыткам улучшить обучение с подкреплением при помощи самого обучения с подкреплением.

Авторы статьи Evolving Reinforcement Learning Algorithms формулируют поиск наилучшего метода путем исследования пространства вычислительных графов, с помощью которых считается лосс-функция для value-based model-free RL для оптимизации агента. Полученные алгоритмы не зависят от конкретной среды и могут работать на новых окружениях.

Помимо этого подход авторов находит алгоритмы, которые показывают лучшее качество на классических RL задачах, а также в играх Atari.

Докладчик: Юрий Белоусов.

"Fast reinforcement learning with generalized policy updates"

Одной из важных проблем в обучении с подкреплением является то, что зачастую, чтобы выучить удовлетворительную политику, нужно провести достаточно большое число взаимодействий агента с окружением.

Авторами рассматриваемой статьи предлагается решать эту проблему с помощью подхода «разделяй и властвуй».

Часто, сложную задачу можно представить в виде последовательно или параллельно выполняемых простых задач. Для такого перехода авторами вводятся обобщенные версии policy evaluation и improvement. Таким образом, можно использовать решение одной задачи для решения других.

Решение авторов помогает добиться сильного прироста в скорости сходимости алгоритмов обучения с подкреплением (алгоритм сходится на несколько порядков быстрее Q-learning).

Докладчик: Сергей Полежаев.

"Evolving Reinforcement Learning Algorithms"

Существует множество различных применений обучения с подкреплением: начиная с настольных игр и заканчивая беспилотными системами. Однако, не так много работ посвящено попыткам улучшить обучение с подкреплением при помощи самого обучения с подкреплением.

Авторы статьи Evolving Reinforcement Learning Algorithms формулируют поиск наилучшего метода путем исследования пространства вычислительных графов, с помощью которых считается лосс-функция для value-based model-free RL для оптимизации агента. Полученные алгоритмы не зависят от конкретной среды и могут работать на новых окружениях.

Помимо этого подход авторов находит алгоритмы, которые показывают лучшее качество на классических RL задачах, а также в играх Atari.

Докладчик: Юрий Белоусов.

- Категория

- Участок

Комментарии выключены